در دنیای سئو (SEO) و بهینهسازی برای موتورهای جستجو، مفهوم “کرال باجت” (Crawl Budget) یکی از کلیدیترین مباحث است که تأثیر زیادی بر روی دیده شدن و رتبهبندی وبسایتها دارد.

کرال باجت چیست؟ ترفندهای بهبود Crawl Budget

Crawl Budget یا “بودجه خزیدن” به تعداد صفحاتی اشاره دارد که یک موتور جستوجو مانند گوگل در یک بازه زمانی مشخص از یک وبسایت بازدید و ایندکس میکند. در واقع، این مفهوم به ظرفیت خزندههای اطلاعاتی اشاره دارد که برای مرور و تحلیل وبسایتها در دسترس هستند. فهمیدن و مدیریت Crawl Budget برای بهینهسازی سئوی وبسایت و افزایش حضور آن در نتایج جستوجو بسیار حیاتی است.

عوامل تعیینکننده Crawl Budget

تعدادی از عوامل میتوانند بر مقدار Crawl Budget تأثیر بگذارند:

- کیفیت محتوای سایت: سایتهایی که محتوای با کیفیت و مفیدی دارند، معمولاً در اولویت خزندهها قرار میگیرند. در مقابل، محتوای تکراری یا بیکیفیت میتواند باعث کاهش Crawl Budget شود.

- ساختار سایت: یک ساختار منظم و منسجم وبسایت، دسترسی خزندهها به صفحات مختلف را تسهیل میکند. استفاده از نقشههای سایت (sitemap) و فایل robots.txt نیز میتواند به بهینهسازی این فرآیند کمک کند.

- سرعت بارگذاری صفحات: بارگذاری سریع صفحات وبسایت میتواند تأثیر مثبتی بر Crawl Budget داشته باشد، زیرا خزندهها قابلیت مرور صفحات بیشتری را در زمان محدود دارند.

- تعداد و کیفیت لینکهای ورودی: لینکهای ورودی به وبسایت از صفحات دیگر نیز میتوانند به خزندهها کمک کنند تا سریعتر به محتوای جدید دسترسی پیدا کنند.

چگونه Crawl Budget را بهینهسازی کنیم؟

بهینهسازی Crawl Budget به چندین روش امکانپذیر است:

- حذف صفحات بیاستفاده یا تکراری: بررسی و حذف صفحاتی که هیچ ورودی یا ترافیکی ندارند، میتواند تمرکز خزندهها را به سمت صفحات مهمتر جلب کند.

- استفاده از فایل robots.txt: با استفاده از این فایل میتوانید به خزندهها بگویید که کدام صفحات را باید ایندکس کنند و کدام صفحات را نادیده بگیرند.

- ایجاد نقشه سایت: نقشه سایت به خزندهها کمک میکند تا به راحتی صفحات جدید یا بهروزرسانیشده را پیدا کنند.

- بهینهسازی سرعت بارگذاری صفحات: فشردهسازی تصویر، استفاده از کشینگ و انتخاب هاست مناسب میتواند به بهبود سرعت بارگذاری کمک کند.

Crawl Budget یکی از مفاهیم کلیدی در سئوی وبسایت است که میتواند تأثیر زیادی بر دیدهشدن محتوای شما در نتایج جستوجو داشته باشد. با درک بهتر این مفهوم و بهینهسازی آن، میتوانید شانس خود را برای جذب ترافیک بیشتر و بهبود رتبهبندی وبسایت افزایش دهید. برای دستیابی به بهترین نتیجه، نیاز است که به این نکات به طور مداوم توجه شود و وبسایت بهروز نگهداری شود.

چرا گوگل بودجه خزش را برای وبسایتها تعیین میکند؟

گوگل، بهعنوان بزرگترین موتور جستجوی جهان، هر روز حجم عظیمی از داده را پردازش میکند. برای مدیریت این حجم داده و ارائه نتایج جستجوی مرتبط و به موقع، الگوریتمهای پیچیدهای را به کار میگیرد. یکی از جنبههای کلیدی این الگوریتمها، “بودجه خزش” (Crawl Budget) است که محدودیتی را برای تعداد صفحات وبسایتی که رباتهای خزنده گوگل (Googlebot) میتوانند در یک بازه زمانی مشخص بخزند، تعیین میکند. این محدودیت، نه یک مانع، بلکه یک مکانیسم مدیریت منابع است که نقش حیاتی در کارایی و اثربخشی موتور جستجو دارد. در ادامه به بررسی دلایل تعیین بودجه خزش توسط گوگل میپردازیم:

1. مدیریت منابع و جلوگیری از اضافه بار: اینترنت شامل میلیاردها صفحه وب است. اگر گوگل اجازه دسترسی نامحدود به رباتهای خود را برای خزیدن در تمامی صفحات هر وبسایت بدهد، با حجم عظیمی از درخواستها مواجه خواهد شد که منجر به overload سرورهای گوگل و کندی چشمگیر در ارائه نتایج جستجو برای همه کاربران میشود. بودجه خزش، به عنوان یک مکانیسم کنترل، از این اتفاق جلوگیری میکند.

2. تمرکز بر صفحات مهمتر: بودجه خزش گوگل را قادر میسازد تا بر صفحات مهمتر و با ارزشتر یک وبسایت تمرکز کند. صفحاتی که از نظر سئو بهینهسازی شدهاند، محتوای با کیفیت دارند و از لحاظ ساختاری به خوبی سازماندهی شدهاند، شانس بیشتری برای خزیده شدن توسط رباتهای گوگل و قرارگیری در نتایج جستجو دارند. بنابراین، بودجه محدود خزش، گوگل را مجبور به اولویتبندی میکند.

3. بهبود سرعت و کارایی موتور جستجو: با محدود کردن تعداد صفحات خزیده شده در هر وبسایت، گوگل میتواند منابع خود را به طور مؤثرتری تخصیص دهد و سرعت کلی پردازش اطلاعات و ارائه نتایج جستجو را بهبود بخشد. این امر منجر به تجربهای بهتر برای کاربران میشود.

4. جلوگیری از سوء استفاده: برخی از وبسایتها ممکن است به طور عمدی با ایجاد تعداد زیادی صفحه بیکیفیت و تکراری، سعی در دستکاری نتایج جستجو داشته باشند. بودجه خزش به گوگل کمک میکند تا این تلاشها را تشخیص داده و از سوء استفاده از منابع خود جلوگیری کند.

5. بهینهسازی تجربه کاربری: با تمرکز بر صفحات با کیفیت بالاتر، گوگل میتواند اطمینان حاصل کند که کاربران نتایج مرتبطتر و دقیقتری را دریافت میکنند. این امر در نهایت به بهبود تجربه کاربری و افزایش رضایت کاربران منجر میشود.

در نهایت، بودجه خزش گوگل نه یک محدودیت دست و پاگیر، بلکه یک مکانیسم ضروری برای مدیریت منابع، تضمین کارایی، و بهبود کیفیت نتایج جستجو است. وبمسترها باید با درک این مکانیسم و بهینهسازی وبسایت خود برای خزش مؤثر، از حداکثر پتانسیل آن استفاده کنند. این امر شامل بهینهسازی ساختار سایت، ایجاد نقشه سایت (Sitemap)، استفاده از robots.txt و پیروی از بهترین شیوههای سئو میشود.

نظر گوگل درباره اهمیت کرال باجت در وبسایتهای مختلف چیست؟

در دنیای سئو، درک مفهوم “کرال باجت” (Crawl Budget) برای موفقیت حیاتی است. اگرچه گوگل بهطور رسمی عدد دقیقی برای کرال باجت هر وبسایت اعلام نمیکند، اما اهمیت آن برای رتبهبندی و دیده شدن در نتایج جستجو غیرقابل انکار است. بهطور خلاصه، کرال باجت میزان زمانی است که رباتهای گوگل (Googlebot) برای خزیدن (crawling) و ایندکس کردن صفحات وبسایت شما اختصاص میدهند. هر چه کرال باجت شما بیشتر باشد، احتمال اینکه گوگل صفحات بیشتری از سایت شما را ایندکس کند و در نتیجه، شانس دیده شدن محتواهایتان در نتایج جستجو افزایش مییابد.

گوگل به صراحت به کرال باجت بهعنوان یک متریک قابل اندازهگیری و کنترل مستقیم اشاره نمیکند، اما از طریق الگوریتمهای خود، به طور غیرمستقیم آن را مدیریت میکند. در واقع، گوگل با توجه به فاکتورهای مختلفی، تصمیم میگیرد که چه مقدار از زمان خود را به هر وبسایت اختصاص دهد. این فاکتورها شامل موارد زیر میشوند:

- اهمیت و کیفیت وبسایت: وبسایتهایی با اعتبار بالا، محتوای با کیفیت، و بک لینکهای قوی، کرال باجت بیشتری دریافت میکنند. گوگل این وبسایتها را ارزشمندتر میداند و در نتیجه بیشتر به آنها توجه میکند.

- ساختار سایت و نقشه سایت (Sitemap): یک ساختار سایت منظم و منطقی و ارائه یک نقشه سایت XML به گوگل، کمک شایانی به رباتهای خزنده در پیمایش و دسترسی به صفحات میکند. این امر باعث افزایش کارایی و استفاده بهینه از کرال باجت میشود.

- سرعت بارگذاری صفحات: صفحات با سرعت بارگذاری پایین، باعث هدر رفتن کرال باجت میشوند. گوگل زمان زیادی را صرف صفحات کند نمیکند و ممکن است از ایندکس کردن آنها صرف نظر کند.

- تعداد صفحات: وبسایتهای با تعداد صفحات بسیار زیاد، نیاز به کرال باجت بیشتری دارند. استفاده از روشهای مناسب برای مدیریت تعداد صفحات و اولویتبندی آنها ضروری است.

- محتوای تکراری و لینکهای شکسته: وجود محتوای تکراری یا لینکهای شکسته، باعث سردرگمی رباتهای گوگل شده و از کارایی کرال باجت میکاهد.

- استفاده از robots.txt: فایل robots.txt به گوگل میگوید کدام بخشها را نباید خزیده و ایندکس کند. استفاده صحیح و دقیق از این فایل برای مدیریت کرال باجت ضروری است. استفاده نادرست میتواند منجر به از دست رفتن کرال باجت شود.

بهینهسازی کرال باجت: اگرچه نمیتوان کرال باجت را بهطور مستقیم کنترل کرد، اما با بهینهسازی موارد ذکر شده در بالا، میتوان از آن بهطور مؤثرتری استفاده کرد. تمرکز بر ارائه محتوای با کیفیت، بهبود سرعت سایت، استفاده از نقشه سایت، و رفع مشکلات ساختاری، میتواند به افزایش کرال باجت و در نتیجه بهبود رتبهبندی سایت در گوگل کمک کند. در نهایت، بهینهسازی کرال باجت، بخشی از یک استراتژی سئو جامع و موفق است و باید در کنار سایر تکنیکهای سئو بهکار گرفته شود. عدم توجه به این موضوع میتواند به کاهش دیدهشدن وبسایت و در نتیجه کاهش ترافیک منجر شود.

چه وبسایتهایی باید به کرال باجت اهمیت دهند؟

در دنیای پویای سئو و بهینهسازی موتورهای جستجو، درک مفاهیم اساسی همچون “کرال باجت” (Crawl Budget) برای موفقیت آنلاین حیاتی است. کرال باجت به میزان منابعی که موتورهای جستجو مانند گوگل برای خزیدن (Crawling) و ایندکس کردن صفحات وبسایت شما اختصاص میدهند، اشاره دارد. هرچه کرال باجت بیشتر باشد، احتمال اینکه موتور جستجو صفحات بیشتری از وبسایت شما را ببیند و ایندکس کند، بالاتر خواهد بود. اما همه وبسایتها به یک اندازه به کرال باجت اهمیت نمیدهند. در این بخش به بررسی وبسایتهایی که باید بیشترین توجه را به مدیریت کرال باجت خود داشته باشند، خواهیم پرداخت.

به طور کلی، وبسایتهای زیر باید به طور ویژه به کرال باجت خود اهمیت دهند:

- وبسایتهای بسیار بزرگ با تعداد صفحات زیاد: وبسایتهایی با دهها هزار یا میلیونها صفحه، به طور بالقوه با محدودیت کرال باجت مواجه هستند. اگر گوگل نتواند تمام صفحات را بهطور مؤثر خزیده و ایندکس کند، محتوای ارزشمند ممکن است از دید جستجوگران پنهان بماند. مدیریت دقیق لینکها، استفاده از نقشه سایت (Sitemap) و ساختار مناسب وبسایت در این مواقع حیاتی است.

- وبسایتهای با محتوای پویا و به روزرسانی مداوم: وبسایتهای خبری، فروشگاههای آنلاین با کاتالوگ محصولات بزرگ و پلتفرمهای محتوا محور با آپدیتهای مکرر، نیازمند کرال باجت بیشتری هستند. به روزرسانیهای مکرر میتوانند صفحات قدیمی را از ایندکس خارج کرده و کرال باجت را به صفحات جدیدتر هدایت کنند. بنابراین، بهینهسازی ساختار وبسایت برای مدیریت مؤثر این به روزرسانیها ضروری است.

- وبسایتهای با محتوای بسیار مشابه: وبسایتهایی که محتواهای تکراری یا مشابه زیادی دارند، ریسک هدر رفتن کرال باجت را به دلیل بیارزشی محتوا برای موتور جستجو دارند. بهینهسازی محتوای تکراری و استفاده از ویژگیهای “canonical” میتواند این مشکل را حل کند.

- وبسایتهای e-commerce با فیلترهای زیاد: وبسایتهای تجارت الکترونیک با امکان فیلتر کردن محصولات بر اساس ویژگیهای مختلف، میتوانند تعداد زیادی URL پویا تولید کنند. مدیریت این URLها و جلوگیری از ایجاد صفحات تکراری یا بیارزش برای کرال باجت بسیار مهم است. استفاده از تکنیکهای مناسب مانند URL rewriting میتواند به این امر کمک کند.

- وبسایتهایی که تازه راهاندازی شدهاند: وبسایتهای جدید برای دیده شدن در نتایج جستجو نیاز به ایندکس شدن سریع دارند. بهبود کرال باجت از طریق تکنیکهای مختلف، مانند ارائه نقشه سایت به گوگل، میتواند به این امر کمک کند.

در نهایت، به یاد داشته باشید که مدیریت کرال باجت فرایندی مداوم و بهینه سازی شده است. نظارت بر گزارشهای کنسول جستجوی گوگل (Google Search Console) برای فهمیدن چگونگی خزش گوگل و شناسایی مشکلات بالقوه در کرال باجت، ضروری است. با پیادهسازی استراتژیهای مناسب سئو و بهینهسازی فنی، میتوانید از کرال باجت خود به نحو احسن استفاده کرده و رتبه وبسایت خود را در نتایج جستجو بهبود بخشید.

نحوه عملکرد کرال باجت

کُرال باجت (Crawl Budget) یکی از مفاهیم کلیدی در بهینهسازی موتورهای جستجو (SEO) است که به شدت میتواند روی رتبهبندی وبسایتها تأثیر بگذارد. در ادامه، به بررسی نحوه عملکرد کرال باجت و مراحل مختلف فرآیند خزش و ایندکس کردن پرداخته خواهد شد.

کشف (Discovery)

کشف اولین مرحلهای است که کراولرها برای شناسایی صفحات وب جدید و بهروزرسانی صفحات موجود انجام میدهند. موتورهای جستجو از طریق لینکها، محتوای جدید را پیدا کرده و به وبسایتها و صفحات مختلف سر میزنند. این فرآیند میتواند شامل لینکهای داخلی، بکلینکها و حتی فایلهای Sitemap باشد.

دسترسی به فایل Robots.txt

فایل Robots.txt یک راهنمای برای موتورهای جستجو است که مشخص میکند کدام صفحات باید خزیده شوند و کدام صفحات نباید. این فایل به کراولرها کمک میکند تا منابع غیرضروری را نادیده بگیرند و تمرکز خود را بر روی صفحات مهمتری که به سئو مرتبط هستند، بگذارند. به همین دلیل، مدیریت مناسب این فایل برای اطمینان از خزیدن مؤثر وبسایت حائز اهمیت است.

خزش

خزش (Crawling) به فرآیند جمعآوری دادهها توسط کراولرها از وبسایتها اطلاق میشود. به هنگام خزش، کراولرها با استفاده از الگوریتمهای خاصی صفحات را بازدید کرده و محتوا، لینکها و دیگر اطلاعات را جمعآوری میکنند. این فرآیند میتواند بهصورت پیوسته و با حساب کاربری متفاوت باشد، که در نتیجه آن، وبسایتها به روزرسانی میشوند و اطلاعات جدیدی برای ایندکس کردن به دست میآورند.

ایندکس کردن (Indexing)

پس از خزش، اطلاعات جمعآوریشده از صفحات وب در پایگاه داده موتور جستجو ایندکس میشود. ایندکس کردن شامل فرآیند ذخیرهسازی و سازماندهی دادهها است بهطوریکه موتور جستجو بتواند به راحتی و سریع به نتایج جستجو دسترسی پیدا کند. ایندکس کنندهها به جستوجو و تحلیل محتوا، عنوانها و متا دیتاها میپردازند تا بتوانند صفحات را براساس ردهبندی معین کنند.

تبادل اطلاعات

تبادل اطلاعات فرایند تحلیل و سنجش دادههای فراهمشده توسط Crawl و Indexing است. موتورهای جستجو برای تأمین تجربیات کاربری بهتر، به دنبال تاخیر یا به روزرسانی اطلاعات وبسایتها هستند. از این رو، وبسایتها باید بهطور منظم بهروز شوند و محتوای جدیدی منتشر کنند تا موتورهای جستجو دائماً آنها را شناسایی و ایندکس کنند.

رتبهبندی (Ranking)

رتبهبندی این است که چگونه موتورهای جستجو نتایج را بر اساس معیارهای معین در صفحات ایندکس شده تنظیم میکنند. این معیارها میتوانند شامل کیفیت محتوا، بکلینکها، تعاملات کاربران و بسیاری از عوامل دیگر باشند. در نهایت، هدف این است که بهترین و مرتبطترین نتایج برای کلمات کلیدی جستجو شده کاربر ارائه شود.

نمایش نتایج بر اساس جستجوی کاربر

موتورهای جستجو نتایج را بر اساس الگوریتمها و معیارهای خاصی نمایش میدهند و این نتایج بر اساس تعامل کاربر، تجربه کاربری و بهروزرسانیهای اخیر متفاوت خواهد بود. بنابراین، سئوکاران باید روندها و تغییراتی که ممکن است بر عملکرد صفحات تأثیر بگذارد را زیر نظر داشته باشند.

خزیدن صفحه بعدی

بهمنظور بهینهسازی کرال باجت و جلب توجه موتورهای جستجو، وبسایتها باید به صورت مداوم محتوای جدید و مرتبط تولید کنند. این تولید محتوا شامل ایجاد لینکهای داخلی و بالابردن کیفیت هر یک از صفحات است. همچنین، با دقت به ساختار وبسایت و بهینهسازی آن، میتوان کاری کرد که کراولرها صفحات بیشتری را در کمتر زمان خزیده و اطلاعات آنها را ایندکس کنند.

مدیریت و بهینهسازی کرال باجت یکی از عوامل مهم در موفقیت سئو هر وبسایت بهشمار میآید.

اهمیت کرال باجت در سئو

در دنیای رقابتی سئو، بهینهسازی موتورهای جستجو، صرفاً به تولید محتوای با کیفیت محدود نمیشود. یکی از فاکتورهای حیاتی که اغلب نادیده گرفته میشود، اما نقش تعیینکنندهای در موفقیت استراتژی سئو دارد، کرال باجت (Crawl Budget) است. در این قسمت، به بررسی دقیق اهمیت کرال باجت و روشهای بهینهسازی آن خواهیم پرداخت.

کرال باجت، میزان منابعی است که موتورهای جستجو مانند گوگل، برای خزیدن (Crawl) و ایندکس کردن صفحات وب سایت شما اختصاص میدهند. به زبان سادهتر، این نشان میدهد که گوگل چقدر وقت و انرژی صرف بررسی صفحات سایت شما میکند. هرچه کرال باجت شما بالاتر باشد، گوگل صفحات بیشتری از سایت شما را به سرعت ایندکس و رتبهبندی میکند، که به نوبه خود منجر به افزایش دیدهشدن و ترافیک ارگانیک سایت میشود.

چرا کرال باجت مهم است؟

- ایندکس شدن صفحات: بدون کرال باجت کافی، موتورهای جستجو قادر به یافتن و ایندکس کردن تمام صفحات وب سایت شما نخواهند بود. این به ویژه برای وب سایتهای بزرگ با تعداد صفحات زیاد، اهمیت بیشتری پیدا میکند. صفحات ایندکس نشده، در نتایج جستجو ظاهر نمیشوند و از مزایای ترافیک ارگانیک محروم میمانند.

- سرعت ایندکس شدن: کرال باجت بالاتر، سرعت ایندکس شدن صفحات جدید و بهروزرسانیهای موجود را افزایش میدهد. این امر بسیار حائز اهمیت است، بهخصوص در مواردی که نیاز به انتشار سریع محتوا و بهروزرسانیهای فوری دارید.

- بهینهسازی رتبهبندی: گوگل برای رتبهبندی صفحات، از سیگنالهای مختلفی استفاده میکند. یکی از این سیگنالها، فرکانس خزش صفحات است. صفحاتی که بیشتر توسط گوگل خزیده میشوند، معمولا رتبهبندی بهتری دریافت میکنند.

- کاهش ریسک حذف از ایندکس: در مواردی که وب سایتی دارای مشکلات فنی مانند خطاهای 404 یا لینکهای شکسته باشد، کرال باجت محدود میتواند منجر به عدم شناسایی و حل سریع این مشکلات شود. این میتواند در نهایت به حذف برخی صفحات از ایندکس منجر شود.

بهینهسازی کرال باجت:

بهینهسازی کرال باجت نیازمند یک استراتژی جامع است که شامل موارد زیر میشود:

- ساختار سایت: استفاده از ساختار درختی واضح و ساده، به گوگل کمک میکند تا به راحتی تمام صفحات سایت را پیدا کند. از استفاده از لینکهای زیاد و پیچیده خودداری کنید.

- نقشه سایت (Sitemap): ارسال نقشه سایت XML به گوگل وبمستر تولز، به گوگل میگوید که کدام صفحات مهم هستند و باید اولویت بالاتری برای خزیدن داشته باشند.

- robots.txt: بهدرستی پیکربندی کنید تا گوگل بداند کدام صفحات را نباید خزیده کند. از مسدود کردن صفحات مهم خودداری کنید.

- لینکهای داخلی: استفاده از لینکهای داخلی مناسب و مرتبط، به گوگل کمک میکند تا به راحتی بین صفحات مختلف سایت شما حرکت کند.

- بهینهسازی سرعت سایت: سرعت بالای سایت، منابع کمتری از کرال باجت را مصرف میکند. سایتهای کند، ممکن است کرال باجت کمتری دریافت کنند.

- بهینهسازی موبایل: گوگل اولویت بیشتری برای سایتهایی که به خوبی برای موبایل طراحی شدهاند قائل است.

کرال باجت یک فاکتور حیاتی در سئو است که اغلب نادیده گرفته میشود. با درک اهمیت آن و پیادهسازی استراتژیهای بهینهسازی مناسب، میتوانید از حداکثر پتانسیل سایت خود برای جذب ترافیک ارگانیک استفاده کنید. به یاد داشته باشید که بهبود کرال باجت یک فرآیند مداوم است که نیاز به نظارت و بهروزرسانی دارد. استفاده از ابزارهای تحلیل سئو میتواند در نظارت بر کرال باجت و شناسایی مشکلات احتمالی کمک شایانی کند.

نحوه بودجهبندی منابع گوگل برای وبسایتها

گوگل برای ایندکس کردن و رتبهبندی صفحات وب، از منابع محدودی استفاده میکند. این منابع شامل قدرت پردازش سرورهایش، پهنای باند و زمان خزش (Crawling) رباتهای گوگل (Googlebot) است. گوگل این منابع را بهطور هوشمندانه بین میلیاردها صفحه وب توزیع میکند، و این توزیع، بهطور ضمنی یک سیستم «بودجهبندی» را تشکیل میدهد. اگرچه گوگل جزئیات دقیقی از الگوریتم تخصیص منابع خود منتشر نمیکند، درک مفاهیم اساسی آن برای بهینهسازی وبسایت و بهبود سئو ضروری است. در این بخش، به دو عامل کلیدی در این فرآیند، یعنی میزان نیاز به خزش و سرحد خزش، میپردازیم.

میزان نیاز به خزش (Crawl Demand)

میزان نیاز به خزش، نشاندهندهی میزان درخواست گوگل برای خزیدن و ایندکس کردن صفحات وبسایت شماست. این میزان تحت تأثیر عوامل مختلفی قرار میگیرد، از جمله:

- تعداد صفحات: وبسایتهای بزرگتر با صفحات بیشتر، طبیعتاً نیاز به خزش بیشتری دارند.

- فرکانس بهروزرسانی محتوا: وبسایتهایی که مرتباً محتواهای جدید منتشر میکنند، نیاز به خزش بیشتری دارند تا گوگل از تغییرات آگاه شود.

- کیفیت محتوا: صفحات با کیفیت بالاتر و مرتبطتر با کلمات کلیدی هدف، احتمالاً نیاز به خزش بیشتری دارند، زیرا گوگل تمایل دارد به این صفحات اهمیت بیشتری بدهد.

- پیوندهای داخلی و خارجی: ساختار لینکدهی داخلی قوی و دریافت بک لینکهای با کیفیت از وبسایتهای معتبر، میتواند نیاز به خزش را افزایش دهد. این به گوگل نشان میدهد که صفحات شما مرتبط و با ارزش هستند.

- نقشه سایت (Sitemap): ارسال نقشه سایت XML به گوگل، به رباتهای آن کمک میکند تا بهطور مؤثرتر صفحات وبسایت شما را پیدا کنند و نیاز به خزش را به طور مؤثری مدیریت کنند. یک نقشه سایت بهروزرسانی شده، بسیار مهم است.

- محتوای پویا: وبسایتهایی با محتواهای پویا (مانند وبلاگها با پستهای جدید روزانه) به مدیریت دقیقتری از نیاز به خزش نیاز دارند.

هر چه وبسایت شما ارزشمندتر و بهروزتر باشد، میزان نیاز به خزش آن بیشتر خواهد بود. هدف، یافتن تعادلی بین نیاز به خزش و توانایی گوگل در پاسخگویی به آن است.

سرحد خزش (Crawl Capacity Limit/Host Load)

سرحد خزش، حداکثر میزان خزشی است که گوگل برای یک وبسایت خاص در یک بازه زمانی مشخص تعیین میکند. این محدودیت، به منظور جلوگیری از بارگذاری بیش از حد سرورهای گوگل و اطمینان از اینکه رباتهای گوگل منابع خود را به طور عادلانه بین وبسایتهای مختلف توزیع میکنند، اعمال میشود. عوامل مختلفی در تعیین سرحد خزش مؤثرند، از جمله:

- سرعت سرور: سرورهای کندتر، ظرفیت خزش کمتری را برای وبسایت شما به همراه دارند. گوگل ممکن است برای جلوگیری از تأخیر در خزش، سرحد خزش را کاهش دهد.

- ساختار وبسایت: ساختار وبسایت نامناسب و پیچیده، میتواند منجر به افزایش زمان خزش و در نتیجه کاهش ظرفیت خزش شود.

- پاسخ سرور: اگر سرور شما بهطور مداوم پاسخهای 5xx (خطاهای سرور) یا 4xx (خطاهای کاربر) برگرداند، گوگل ممکن است سرحد خزش را کاهش دهد.

- استفاده از robots.txt: استفاده درست از فایل robots.txt برای جلوگیری از خزش صفحات غیرضروری، میتواند به افزایش ظرفیت خزش کمک کند.

- تعداد رباتهای خزش: در حالی که تعداد رباتها در سرحد خزش نقش دارد، اما مهمتر از آن سرعت پاسخگویی سرور و بهینهسازی وبسایت است.

افزایش سرعت سرور، بهبود ساختار وبسایت و استفاده از فایل robots.txt بهینه شده، راههایی برای افزایش سرحد خزش وبسایت شما هستند. اگر سرحد خزش شما کم باشد، ممکن است برخی از صفحات شما به طور کامل ایندکس نشوند. بنابراین، بهینهسازی وبسایت برای سرعت و کارایی، ضروری است.

در نهایت، بهینهسازی وبسایت برای مدیریت مؤثر نیاز به خزش و تطابق با سرحد خزش، تضمین کنندهی ایندکس و رتبهبندی بهتر در نتایج جستجوی گوگل خواهد بود. توجه به این دو عامل، کلیدی برای سئو موفق و کسب ترافیک ارگانیک بیشتر است.

چگونه بودجه خزش وبسایت را بررسی کنیم؟

در دنیای بهینهسازی موتور جستجو (SEO)، بودجه خزش (Crawl Budget) به تعداد صفحاتی اطلاق میشود که یک موتور جستجو مانند گوگل در یک دوره معین میتواند به وبسایت شما سر بزند و آنها را ایندکس کند. بررسی و بهینهسازی بودجه خزش، میتواند تأثیر قابل توجهی بر افزایش دید و جایگاه وبسایت شما در نتایج جستجو داشته باشد. در این قسمت به بررسی روشهای مختلف برای ارزیابی و بهینهسازی بودجه خزش وبسایت میپردازیم.

۱. درک مفهوم بودجه خزش

قبل از اقدام به بررسی، مهم است که درک دقیقی از مفهوم بودجه خزش داشته باشید. این بودجه تحت تأثیر عواملی مانند حجم محتوا، کیفیت صفحات، سرعت بارگذاری و ساختار لینکهای داخلی قرار میگیرد. در واقع، موتورهای جستجو به صفحات با کیفیت و کاربردی بیشتر اهمیت میدهند.

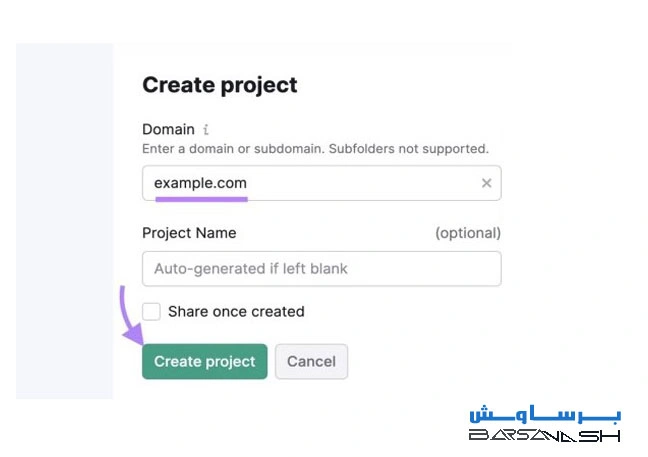

۲. استفاده از Google Search Console

یکی از بهترین ابزارها برای بررسی بودجه خزش، Google Search Console است. در این ابزار میتوانید موارد زیر را بررسی کنید:

- تعداد صفحاتی که ایندکس شدهاند: این اطلاعات به شما کمک میکند تا بررسی کنید که آیا تمامی صفحات مهم شما توسط گوگل ایندکس شدهاند یا خیر.

- خطاهای خزش: با مشاهده خطاهای ثبت شده، میتوانید مشکلاتی را که ممکن است باعث کاهش بودجه خزش شما شده باشد شناسایی کنید.

- آمار خزش: در قسمت “Coverage” میتوانید آمار دقیقی از صفحاتی که گوگل توانسته است آنها را بخزد و ایندکس کند، مشاهده کنید.

۳. آنالیز فایل robots.txt

فایل robots.txt به موتورهای جستجو میگوید که کدام صفحات باید خزش شوند و کدام صفحات باید نادیده گرفته شوند. بهینهسازی این فایل و اطمینان از اینکه هیچ صفحه مهمی از خزش و ایندکس خارج نشده باشد، میتواند به بهبود بودجه خزش کمک کند.

۴. بهینهسازی ساختار داخلی و لینکها

سیستم لینکهای داخلی شما نقش مهمی در تعیین بودجه خزش دارد. با ایجاد لینکهای داخلی مناسب و توجه به صفحات مهم، میتوانید به موتور جستجو کمک کنید تا ساختار وبسایت شما را بهتر درک کند. همچنین، لینکدهی به صفحات کمتر ایندکس شده میتواند به آنها در تخصیص بودجه خزش کمک کند.

۵. کاهش حجم صفحات بیاستفاده

صفحات تکراری، بیکیفیت یا غیرضروری میتوانند به طور منفی بر روی بودجه خزش شما تأثیر بگذارند. شناسایی و حذف این صفحات یا استفاده از ریدایرکتها میتواند به بهینهسازی و بهبود بودجه خزش کمک کند.

۶. بررسی زمان بارگذاری صفحات

سرعت بارگذاری صفحات یکی دیگر از عوامل مؤثر بر بودجه خزش است. بهینهسازی زمان بارگذاری میتواند به موتورهای جستجو کمک کند تا سریعتر صفحات شما را بخزند و ایندکس کنند. ابزارهایی مانند Google PageSpeed Insights میتوانند به شما در این زمینه کمک کنند.

۷. نظارت و تجزیه و تحلیل مداوم

پس از اجرای تغییرات، مهم است که به طور مداوم وضعیت بودجه خزش وبسایت خود را نظارت کنید. تجزیه و تحلیل مداوم و بهروزرسانی استراتژیهای خود بر اساس دادههای بهدستآمده میتواند به بهینهتر شدن بودجه خزش کمک کند.

بررسی و بهینهسازی بودجه خزش وبسایت یک فرآیند مستمر و حیاتی در بهبود سئو است. با بهرهگیری از ابزارهای مناسب و انجام اقدامات لازم، میتوانید تأثیر مثبتی بر روی نمای وبسایت خود در نتایج جستجو داشته باشید. به یاد داشته باشید که موفقیت در سئو به صبر و پیوستگی نیاز دارد و همیشه باید خود را با تغییرات الگوریتمهای موتور جستجو وفق دهید.

بهترین روشهای بهبود کرال باجت

بودجه خزش (Crawl Budget) به مقدار زمانی اشاره دارد که موتورهای جستجو برای بررسی و ایندکس کردن صفحات یک وبسایت صرف میکنند. بهینهسازی این بودجه باعث میشود که موتورهای جستجو تمرکز بیشتری بر روی صفحات مهم وبسایت داشته باشند و این امر میتواند به بهبود رتبهبندی سایت در نتایج جستجو منجر شود. در این قسمت بهترین روشهای بهبود کرال باجت را بررسی خواهیم کرد.

حذف ریدایرکتهای اضافه

ریدایرکتها میتوانند به سهولت بهبود تجربه کاربری کمک کنند، اما ریدایرکتهای بیدلیل و اضافی میتوانند سرعت خزش موتورهای جستجو را کاهش دهند. به همین دلیل، باید ریدایرکتهایی که هیچ هدف واقعی ندارند حذف شود. برای این کار میتوانید با استفاده از ابزارهای تحلیل لینک، ریدایرکتهای غیرضروری را شناسایی کرده و آنها را حذف کنید.

صرفهجویی در بودجه خزش

یکی از کلیدهای اصلی در بهینهسازی کرال باجت، صرفهجویی در بودجه خزش است. این بدان معناست که باید توجه ویژهای به صفحاتی که دارای ارزش بیشتری هستند داشته باشید. بهینهسازی صفحات کمارزش و غیرضروری باعث میشود که بیشتر از زمان خزش برای صفحات مهم استفاده شود.

بهینهسازی سرعت سایت

سرعت بارگذاری سایت تأثیر بسیاری بر تجربه کاربری و همچنین بر فرآیند خزش موتورهای جستجو دارد. سایتهایی که کند هستند ممکن است باعث کاهش بودجه خزش شوند. بنابراین، بهینهسازی سرعت بارگذاری از طریق فشردهسازی تصاویر، استفاده از کش مرورگر و بهینهسازی کدها، میتواند در بهبود کرال باجت مؤثر باشد.

بهروزرسانی نقشه سایت

نقشه سایت (Sitemap) یکی از ابزارهای کلیدی برای کمک به موتورهای جستجو در فهم ساختار صفحات وبسایت شما است. بهروزرسانی منظم نقشه سایت، اطمینان میدهد که موتورهای جستجو جدیدترین اطلاعات را در مورد صفحات شما دریافت میکنند. همچنین در بالابردن امکان ایندکس شدن صفحات جدید و حذف صفحات غیرضروری نیز تأثیرگذار است.

طراحی ساختار فکرشده برای وبسایت

ساختار صحیح و منطقی برای وبسایت به موتورهای جستجو کمک میکند تا صفحات را به سهولت شناسایی کنند. طراحی یک هرم منطقی از دستهبندیها و زیر دستهها میتواند بازدیدکنندگان و رباتهای خزش را در پیدا کردن محتوا راحتتر کند. همچنین، پیوندهای داخلی درست و بهینه نیز به انتقال اعتبار (Link Juice) بین صفحات مختلف کمک میکند.

حذف محتواهای تکراری

محتوای تکراری میتواند باعث کاهش اعتبار وبسایت در نظر موتورهای جستجو شود و به هدر رفتن بودجه خزش کمک کند. بنابراین، شناسایی و حذف یا بهینهسازی مقالات تکراری بسیار مهم است. با استفاده از کنسول جستجوی گوگل و ابزارهای سئو میتوان محتوای تکراری را شناسایی و اقدامات لازم را برای حذف یا تغییر آن انجام داد.

با پیادهسازی این روشها، میتوانید به بهبود کرال باجت وبسایت خود کمک کنید و در نتیجه شاهد افزایش کیفیت ایندکس و تجربه کاربری بهتری باشید.

اشتباهایی که بودجه خزش را هدر میدهد!

بودجه خزش (Crawl Budget) محدودیت تعداد صفحاتی است که موتورهای جستجو میتوانند در یک بازه زمانی خاص از وبسایت شما خزش کنند. هدر رفتن این بودجه میتواند به رتبهبندی سایت شما در نتایج جستجو آسیب جدی وارد کند. در این بخش، به بررسی برخی از رایجترین اشتباهاتی که منجر به هدر رفتن بودجه خزش میشوند، میپردازیم.

استفاده از تگ noindex به جای مسدودسازی رباتهای خزنده

استفاده از تگ <meta name="robots" content="noindex"> برای جلوگیری از ایندکس شدن صفحات، درست است. اما اگر هدفتان جلوگیری از خزش صفحه توسط رباتهاست، این روش بهینه نیست. تگ noindex هنوز باعث میشود رباتهای خزنده صفحه را خزش کنند و در نهایت بودجه خزش را هدر میدهند. برای جلوگیری از خزش، باید از فایل robots.txt یا ابزارهای دیگر مسدودسازی رباتها استفاده کنید. این روش به موتورهای جستجو میگوید که حتی به این صفحات مراجعه نکنند و بودجه خزش را برای صفحات مهمتر ذخیره میکنند.

وجود صفحات یتیم

صفحات یتیم صفحاتی هستند که هیچ لینکی از صفحات دیگر وبسایت به آنها اشاره نمیکند. موتورهای جستجو ممکن است به طور اتفاقی به این صفحات برسند، اما در نهایت این صفحات کم ارزش و بلااستفاده، بخشی از بودجه خزش را به خود اختصاص میدهند. شناسایی و حذف یا ادغام این صفحات، به بهینهسازی بودجه خزش کمک شایانی میکند.

استفاده از پارامترهای URL غیرضروری

استفاده از پارامترهای اضافی در آدرسهای URL (مثل ?sort=price&page=2) میتواند منجر به ایجاد نسخههای تکراری از یک صفحه شود. موتورهای جستجو مجبورند تمام این نسخهها را خزش کنند که در نهایت منجر به هدر رفتن بودجه خزش میشود. استفاده از URL canonical یا Canonicalization برای مشخص کردن نسخه اصلی صفحه و جلوگیری از ایجاد نسخههای تکراری، راه حل مناسبی برای این مشکل است.

بیتوجهی به لینکهای شکسته

لینکهای شکسته (404 Error) نه تنها تجربه کاربری ضعیفی را ایجاد میکنند، بلکه باعث هدر رفتن بودجه خزش نیز میشوند. رباتهای خزنده زمانی که به یک لینک شکسته برخورد میکنند، زمان و منابع خود را صرف تلاش برای یافتن صفحهای که وجود ندارد میکنند. به صورت منظم لینکهای وبسایت خود را بررسی کنید و لینکهای شکسته را برطرف یا حذف نمایید. استفاده از ابزارهای SEO میتواند در شناسایی این لینکها به شما کمک کند.

با اجتناب از این اشتباهات، میتوانید بودجه خزش خود را بهینه کرده و اطمینان حاصل کنید که موتورهای جستجو صفحات مهم و با ارزش وبسایت شما را به طور موثر خزش میکنند و در نهایت به بهبود رتبهبندی سایتتان کمک خواهد کرد.

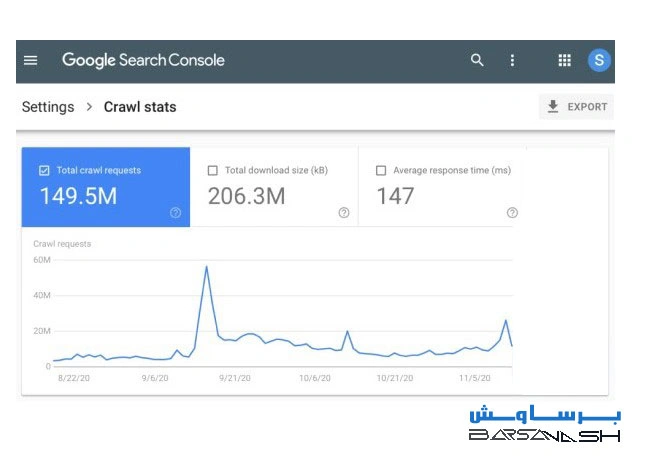

گزارش بودجه خزش از گوگل سرچ کنسول

گوگل برای ایندکس کردن صفحات وب شما از رباتهای خزنده (crawler) استفاده میکند. این رباتها به وبسایت شما مراجعه کرده و محتوا را برای ایندکس کردن در نتایج جستجو تجزیه و تحلیل میکنند. بودجه خزش (Crawl Budget) به میزان محدودی از منابعی اشاره دارد که گوگل برای خزیدن و ایندکس کردن صفحات وبسایت شما اختصاص میدهد. مدیریت موثر بودجه خزش برای رتبهبندی بهتر در نتایج جستجو بسیار حیاتی است. در ادامه به بررسی گزارش بودجه خزش در گوگل سرچ کنسول و تفسیر دادههای آن میپردازیم.

نمودار خزش در طول زمان

یکی از مهمترین بخشهای گزارش بودجه خزش، نمودار نشاندهندهی میزان خزش در طول زمان است. این نمودار به شما نشان میدهد که گوگل در بازههای زمانی مختلف چه تعداد درخواست خزش به وبسایت شما ارسال کرده است. با بررسی این نمودار میتوانید نوسانات در میزان خزش را شناسایی کنید. کاهش ناگهانی در میزان خزش میتواند نشاندهندهی مشکلاتی در وبسایت شما باشد، مانند:

- مشکلات سرور: سرعت پایین سرور یا خطاهای سرور میتواند باعث کاهش میزان خزش شود.

- نقشه سایت (Sitemap) ناکامل یا دارای خطا: اگر نقشه سایت شما بهروز نیست یا حاوی خطا است، گوگل ممکن است نتواند بهطور موثر صفحات وبسایت شما را پیدا کند.

- مسائل مربوط به robots.txt: فایل robots.txt شما ممکن است بهطور غیرعمدی دسترسی رباتهای گوگل را به بخشهایی از وبسایت شما مسدود کند.

- افزایش ناگهانی در تعداد صفحات: افزایش ناگهانی در تعداد صفحات وبسایت میتواند باعث کاهش میزان خزش به ازای هر صفحه شود.

با رصد مداوم این نمودار میتوانید بهموقع مشکلات احتمالی را شناسایی و رفع کنید.

وضعیت هاست (Host Status)

بخش وضعیت هاست در گزارش بودجه خزش نشان میدهد که آیا گوگل میتواند به سرور شما دسترسی داشته باشد یا خیر. اگر وضعیت هاست “Online” باشد، نشاندهندهی دسترسی بدون مشکل است. اگر وضعیت هاست “Offline” یا “Error” باشد، به این معنی است که گوگل قادر به دسترسی به وبسایت شما نیست و باید مشکل را در اسرع وقت رفع کنید. دلایل احتمالی برای این وضعیت عبارتند از:

- مشکلات سرور: خرابی سرور، قطع اینترنت، یا مشکل در تنظیمات DNS.

- مسدود شدن IP آدرس سرور توسط فایروال: فایروال ممکن است دسترسی رباتهای گوگل را مسدود کرده باشد.

- خطاهای DNS: مشکل در سیستم نام دامنه (DNS) میتواند مانع از دسترسی گوگل به سرور شما شود.

گروهبندی درخواستهای خزش (Crawl requests breakdown)

این بخش از گزارش به شما نشان میدهد که درخواستهای خزش از چه منابعی (مثلا از طریق نقشه سایت، پیوندهای داخلی، یا پیوندهای خارجی) انجام شدهاند. این اطلاعات به شما کمک میکند تا متوجه شوید که کدام روشها برای جذب خزش گوگل موثرتر هستند. با تجزیه و تحلیل این دادهها میتوانید استراتژی خزش خود را بهینه کنید و از منابع خزش به طور موثر استفاده کنید. به عنوان مثال، اگر متوجه شدید که تعداد زیادی از درخواستهای خزش از طریق لینکهای خارجی انجام میشود، ممکن است نشاندهندهی کیفیت بالای لینکسازی خارجی شما باشد. در مقابل، اگر تعداد درخواستهای خزش از نقشه سایت کم باشد، میتواند نشاندهندهی نیاز به بهروزرسانی و بهبود نقشه سایت شما باشد. بهطور کلی، تحلیل این بخش به شما کمک میکند تا نقاط قوت و ضعف استراتژی سئو خود را شناسایی کرده و آن را بهبود بخشید.

آمارگیری از وضعیت کرال باجت با ابزارهای سئو

کرال باجت (Crawl Budget) به میزان منابعی که گوگل برای خزش (Crawling) وبسایت شما اختصاص میدهد، اشاره دارد. مدیریت و بهینهسازی این باجت امری حیاتی برای حضور موفق در نتایج جستجو است. یک کرال باجت محدود میتواند منجر به ایندکس نشدن صفحات کلیدی، کاهش رتبه و در نهایت از دست رفتن ترافیک شود. ابزارهای مختلف سئو میتوانند به شما در نظارت و تحلیل کرال باجت کمک کنند تا نقاط ضعف وبسایتتان را شناسایی و اصلاح کنید. در ادامه، به بررسی دو ابزار پرکاربرد، SEMrush و Ahrefs، در زمینه آمارگیری از وضعیت خزش سایت خواهیم پرداخت.

SEMrush ابزاری قدرتمند برای سئو است که امکان نظارت بر کرال باجت را نیز فراهم میکند. با استفاده از گزارشهای مربوط به خزش سایت در SEMrush، میتوانید به اطلاعات ارزشمندی دست یابید. این اطلاعات شامل موارد زیر میشوند:

- تعداد صفحات خزیده شده: SEMrush به شما نشان میدهد که گوگل در چه مدت زمانی چند صفحه از وبسایت شما را خزیده است. با مقایسه این دادهها در بازههای زمانی مختلف، میتوانید روند خزش را بررسی کنید.

- صفحات با خطاهای خزش: این گزارش به شما نشان میدهد کدام صفحات با خطاهایی مانند خطای 404 یا خطاهای سرور مواجه شدهاند و مانع از خزش صحیح گوگل شدهاند.

- زمان صرف شده برای خزش: SEMrush میتواند زمان صرف شده برای خزش هر صفحه را به شما نشان دهد. صفحاتی که زمان خزش زیادی را به خود اختصاص میدهند، میتوانند نشاندهنده مشکلات عملکردی یا محتوای نامناسب باشند.

- نقشه سایت: بررسی هماهنگی نقشه سایت XML شما با گزارشهای خزش SEMrush میتواند به شما در یافتن صفحات از دست رفته در خزش کمک کند.

با تجزیه و تحلیل این دادهها در SEMrush، میتوانید نقاط ضعف وبسایتتان را در زمینه خزش شناسایی کنید و اقدامات اصلاحی لازم را انجام دهید. برای مثال، میتوانید با رفع خطاهای 404، بهینهسازی سرعت بارگذاری صفحات و بهبود ساختار سایت، کرال باجت خود را بهینه کنید.

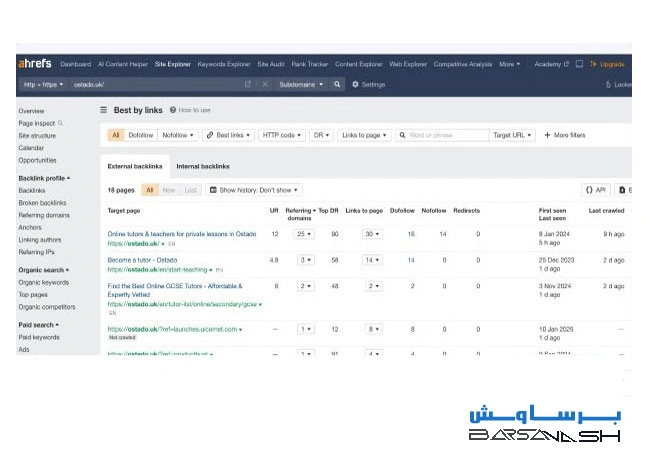

آمارگیری خزش سایت با Ahrefs

Ahrefs نیز مانند SEMrush، ابزاری قدرتمند برای سئو است که امکان تحلیل خزش وبسایت را فراهم میکند. با استفاده از گزارشهای مختلف Ahrefs، میتوانید اطلاعات زیر را به دست آورید:

- تعداد صفحات ایندکس شده: Ahrefs تعداد صفحاتی را که توسط گوگل ایندکس شدهاند، نشان میدهد. تفاوت بین تعداد صفحات خزیده شده و ایندکس شده میتواند نشاندهنده مشکلات در ایندکس شدن صفحات باشد.

- لینکهای خزیده شده: Ahrefs اطلاعاتی در مورد لینکهای داخلی و خارجی خزیده شده توسط گوگل ارائه میدهد که در تشخیص مشکلات در ساختار لینکدهی وبسایت مفید است.

- گزارشهای خطا: مشابه SEMrush، Ahrefs نیز گزارشهایی از خطاهای خزش ارائه میدهد که به شما در شناسایی و رفع مشکلات کمک میکند.

- Crawling Errors: این بخش به طور خاص به شناسایی و دسته بندی خطاهای خزش (مانند 404, 5xx) اختصاص دارد.

با استفاده از Ahrefs، میتوانید روند خزش را به طور دقیقتری دنبال کنید و با شناسایی و رفع مشکلات، کرال باجت خود را به حداکثر برسانید. ترکیب اطلاعات Ahrefs با دادههای گوگل سرچ کنسول، دید کاملی از وضعیت خزش و ایندکس شدن صفحات وبسایتتان به شما ارائه میدهد.

در نهایت، به یاد داشته باشید که استفاده موثر از ابزارهای سئو مانند SEMrush و Ahrefs، تنها بخشی از فرآیند بهینهسازی کرال باجت است. بهینهسازی فنی سایت، ساختار مناسب لینکدهی داخلی و تولید محتوای با کیفیت نیز نقش کلیدی در مدیریت صحیح کرال باجت دارند.

سؤالات متداول درباره Crawl Budget

Crawl Budget یا بودجه خزش، محدودیت منابعی است که موتورهای جستجو مانند گوگل برای خزش وبسایت شما اختصاص میدهند. در این بخش به برخی از سؤالات متداول درباره Crawl Budget پاسخ میدهیم.

چه عواملی بر Crawl Budget تأثیر میگذارند؟

چندین عامل بر میزان Crawl Budget اختصاصیافته به وبسایت شما تأثیر میگذارند، از جمله:

- اهمیت سایت: وبسایتهای با اعتبار و محتوای باکیفیتتر، معمولاً Crawl Budget بیشتری دریافت میکنند. گوگل از الگوریتمهای پیچیدهای برای ارزیابی اعتبار و اهمیت سایت استفاده میکند.

- ساختار سایت: یک ساختار سایت منطقی و بهینه شده با استفاده از نقشه سایت (Sitemap) و لینکهای داخلی موثر، به موتورهای جستجو کمک میکند تا صفحات مهم را راحتتر شناسایی و خزش کنند. یک ساختار پیچیده و نامنظم میتواند منجر به هدر رفتن Crawl Budget شود.

- سرعت بارگذاری سایت: اگر سایت شما سرعت بارگذاری پایینی داشته باشد، موتورهای جستجو زمان بیشتری را برای خزش هر صفحه صرف میکنند و در نتیجه Crawl Budget شما سریعتر تمام میشود.

- تعداد صفحات: وبسایتهای با تعداد صفحات بسیار زیاد، نیاز به Crawl Budget بیشتری دارند. بهینهسازی تعداد صفحات و تمرکز بر محتوای باکیفیت میتواند این مشکل را تا حدودی حل کند.

- کیفیت محتوا: محتوای تکراری، بیکیفیت و یا کم ارزش، Crawl Budget را بدون ارائه هیچ ارزشی مصرف میکند.

- خطاهای سرور: خطاهای 404، 500 و سایر خطاهای سرور میتوانند Crawl Budget را به هدر بدهند و از خزش صفحات مهم جلوگیری کنند.

- استفاده از robots.txt: robots.txt به موتورهای جستجو میگوید که کدام صفحات را نباید خزش کنند. استفاده نادرست از این فایل میتواند منجر به کاهش Crawl Budget شود.

چگونه Crawl Budget خود را مدیریت کنم؟

مدیریت Crawl Budget برای اطمینان از اینکه موتورهای جستجو میتوانند مهمترین صفحات شما را به طور موثر خزش کنند، ضروری است. این کار را میتوانید با اقدامات زیر انجام دهید:

- بهینهسازی ساختار سایت: از یک ساختار سلسله مراتبی منطقی استفاده کنید و از لینکهای داخلی به طور موثر استفاده کنید تا صفحات مهمتر را برجسته کنید.

- ایجاد نقشه سایت (Sitemap): یک نقشه سایت XML به موتورهای جستجو کمک میکند تا همه صفحات سایت شما را به راحتی شناسایی کنند.

- بهبود سرعت بارگذاری سایت: از تکنیکهای مختلف برای بهبود سرعت بارگذاری سایت، مانند بهینهسازی تصاویر و کدها استفاده کنید.

- رفع خطاهای سرور: به طور مرتب سایت خود را برای یافتن و رفع خطاهای سرور بررسی کنید.

- استفاده صحیح از robots.txt: مطمئن شوید که robots.txt به درستی پیکربندی شده است و از مسدود کردن صفحات مهم جلوگیری میکند.

- بهینهسازی محتوا: بر تولید محتوای باکیفیت، مفید و منحصر به فرد تمرکز کنید.

- استفاده از ابزارهای تحلیل: از ابزارهای سئو مانند Google Search Console برای نظارت بر Crawl Budget و شناسایی مشکلات استفاده کنید.

آیا کمبود Crawl Budget همیشه مشکل است؟

نه، لزوماً کمبود Crawl Budget به معنی رتبهبندی پایینتر در نتایج جستجو نیست. اگر وبسایت شما ساختار خوبی داشته باشد و محتوای باکیفیتی ارائه دهد، گوگل میتواند صفحات مهم شما را شناسایی و رتبهبندی کند، حتی اگر Crawl Budget شما محدود باشد. اما در وبسایتهای بزرگتر و پیچیدهتر، مدیریت Crawl Budget بسیار مهمتر میشود.

چگونه میتوانم Crawl Budget خود را افزایش دهم؟

افزایش مستقیم Crawl Budget امکانپذیر نیست. اما با انجام اقدامات ذکر شده در بالا، میتوانید از Crawl Budget موجود خود به طور موثرتر استفاده کرده و به گوگل کمک کنید تا صفحات مهمتر شما را اولویتبندی کند.

نتیجهگیری

درک و مدیریت Crawl Budget برای هر وبسایتی، به خصوص وبسایتهای بزرگ، حیاتی است. با پیروی از این راهنماییها، میتوانید از Crawl Budget خود به طور موثر استفاده کرده و به بهبود رتبهبندی سایت خود در نتایج جستجو کمک کنید. به یاد داشته باشید که سئو یک فرآیند مستمر است و نیاز به نظارت و بهینهسازی مداوم دارد

منبع : barsavash.com